Das Zeitalter der Informatik

Lebenshilfe durch Automation – die Fortschritte in der Informationstechnologie haben unser Leben in den letzten 100 Jahren erheblich erleichtert. Doch von wie viel intellektueller Arbeit sollen Computer uns eigentlich «befreien»? Eine kritische Würdigung.

Informatik war immer schon da. Kommunikation und Informationsverarbeitung sind ein essentieller Teil der menschlichen Kreativität. Jahrhunderte lang war das so selbstverständlich, dass wir uns gar nicht gross darum zu kümmern brauchten. Heute aber ist die Informatik so mächtig geworden, dass sie die Gesellschaften auf tiefgreifende Art verändert. Wir kommen gar nicht darum herum, uns mit ihr auseinanderzusetzen. Um besser zu verstehen, was gerade passiert, müssen wir eine kleine Zeitreise unternehmen. Wir reisen von den Wurzeln der Informatik, der Mathematik, über ihr Grösserwerden als eigene Disziplin bis hin zu den Auswirkungen, die sie heute und in Zukunft auf unser Leben hat. Sie werden danach hoffentlich verstehen, was es mit den Begriffen «Algorithmus» und «Big Data» auf sich hat – und warum so viele Informatikprofessoren darauf drängen, dass sich die Ausbildungen an unseren Schulen verändern.

1. Wie neue Technologien entstehen

Menschen entwickelten sich schon immer mit Hilfe von zwei Werkzeugen weiter. Erstens sammelten sie Erfahrungen mit ihrer Umwelt, machten also Experimente. Zweitens leiteten sie aus diesen Erfahrungen abstrakte Verallgemeinerungen ab, die dann für alle überprüfbar waren. Das taten sie mit Hilfe der Mathematik. Experimente und Mathematik: Das sind seit Jahrtausenden die fundamentalen Werkzeuge zum Erzeugen von neuem Wissen. Immer wieder hat dieses Wissen auch praktische Relevanz, indem es höhere Effizienz schafft. Aus der Wissenschaft können sich neue Technologien entwickeln, deren Anwendung keine hohe Qualifikation braucht und die somit breit nutzbar werden. Solche Technologien entstehen aber nicht einfach garantiert und direkt aus der Wissenschaft. Sie sind in der Geschichte immer schon im Spannungsfeld zwischen Wissenschaft und pragmatischem, realem Experimentieren entstanden. Das war in der Informatik nicht anders, wie wir gleich sehen werden.

Schauen wir uns aber zunächst zwei Beispiele an, um dieses Wechselspiel zwischen Abstraktem und Praktischem zu illustrieren. Der Satz von Pythagoras beispielsweise ist ein Stück exaktes Wissen, das durch eine vollständig mathematisch überprüfbare Argumentation entstand. Der Satz von Pythagoras besagt, dass in jedem rechtwinkligen Dreieck das Quadrat c2 der längsten Seite c (Hypotenuse) gleich der Summe a2 + b2 der Quadrate der kürzeren Seiten a und b (Katheten) ist. Für die praktische Anwendung liefert dieser Satz beispielsweise die Basis für eine Technologie zum Erzeugen von rechtwinkligen Ecken beim Gebäudebau: Weil 52 = 42 + 32, reicht es, mit Seilen ein Dreieck mit Seiten von 5, 4 und 3 Einheiten aufzuspannen. Zwischen den Seilen der Länge 3 und 4 sitzt immer ein rechter Winkel. Kein Bauarbeiter muss dazu den Satz von Pythagoras oder gar dessen Entdeckung verstehen.

Auf der anderen Seite entstanden aber eben auch Vorgehensweisen, die sich nicht zuerst auf Mathematik stützten. Die Entdeckung des Rades, übrigens unabhängig an unterschiedlichen Orten der Welt vor 2000 bis 4000 Jahren, basierte nicht auf der Entdeckung von physikalischen Gesetzen. Die Konzepte der Gravitationskraft und der Reibungskraft waren damals noch unbekannt. Die Räder, genauso wie viele Heilungsverfahren, entstanden durch Probieren, Testen und Anwenden sowie in sich ständig wiederholenden Verbesserungsprozessen. Wieder galt aber: die erzeugten Endprodukte und Technologien konnte man nutzen, ohne die theoretische Herleitung ihrer Funktionsweise zu kennen.

2. Die Automatisierung des logischen Denkens

Schon ziemlich früh kamen Menschen auf die Idee, Teile des Denkprozesses an sich zu automatisieren, und im Grunde liegen hier die Wurzeln der Informatik. Der deutsche Universalwissenschafter Gottfried Wilhelm Leibniz war der erste, der über diese «Automatisierung» der intellektuellen Tätigkeit gesprochen hat. Sein Traum war es, die Mathematik so aufzubauen, dass man in ihr als Sprache exakt alle realen Probleme der Welt formulieren, analysieren und somit lösen kann. Kein Platz mehr für Streitigkeiten, emotionale Argumente und Bauchgefühle bei Entscheidungsprozessen! Der Traum von Leibniz reifte später auch zum Traum seines Landsmannes David Hilbert, eines Mathematikers. Hilbert glaubte fest daran, dass man für alle in der Mathematik formulierbaren Problemstellungen eine Lösung und damit einen oder mehrere Lösungswege finden könne. (Einen solchen Lösungsweg – die ganze Abfolge von Operationen, die schliesslich zur Lösung führen würden – taufte Alan Turing später auf den Namen Algorithmus, aber dazu kommen wir gleich.)

Im Jahr 1930 zerschlug Kurt Gödel die Träume von Leibniz und Hilbert. Er bewies, dass man in der Mathematik Behauptungen formulieren konnte, für die es keine Beweise ihrer Gültigkeit oder Ungültigkeit gibt. Diese Probleme sind mit mathematischen Mitteln nicht lösbar. Diese Erkenntnis war der Beginn einer Spezialisierung, die später zur Informatik werden sollte: Ihre Forscher widmeten sich intensiv ebendieser Frage, ob ein bestimmtes mathematisches Problem mittels einer Methode lösbar war (also ein Algorithmus existieren musste) oder nicht. Darum wurde die Informatik ganz zu Beginn auch schlicht die Wissenschaft der Algorithmen genannt.

Der Anfang der Informatik war also sozusagen umgekehrt zu dem, was sie heute tut. Zu Anfang versuchte man exakt nachzuweisen, dass ein bestimmtes Problem lösbar war, also ein Algorithmus dafür existierte. Später suchte man einen effizienten Algorithmus als eine Abfolge von einfachen Operationen, die alle möglichen Fälle des betrachteten Problems lösen sollten.

Diese mathematischen Operationen wurden von Menschen durchgeführt, lange bevor die erste Hardware (Computer) überhaupt existierte. Als es viel Rechenarbeit gab, zum Beispiel während der Weltkriege, sassen Hunderte von Mitarbeitern in einem Raum und führten die Berechnungen von Algorithmen durch. Angefangen über Informatik zu sprechen haben wir hingegen erst, als die entsprechende Hardware da war und die Algorithmen so genau formuliert wurden, dass es für deren Ausführung keine Improvisationsfähigkeit und somit keine menschliche Intelligenz mehr brauchte.

3. Algorithmen für den Alltag

Die 1970er Jahre brachten dann aus mathematischer Sicht eine kleine Revolution – auch wenn die Menschen sie im Alltag kaum zu sehen bekommen. Die Komplexität eines Algorithmus bemisst sich an der Menge an Rechenarbeit, die er mit sich bringt. Viele Algorithmen für ganz alltägliche Problemstellungen sind exponentiell; das bedeutet, dass eine kleine Erhöhung der Datenmenge zu einer exponentiellen Erhöhung des Arbeitsaufwands führt. So drastisch gar, dass das Alter des Universums nicht reichen würde, um den ganzen Lösungsweg zu beschreiten. In den 1970er Jahren entdeckten Forscher eine Art Abkürzungen, die zu erklären an dieser Stelle zu kompliziert wäre. Man kann es so sagen: Wenn man darauf verzichtet, dass ein Algorithmus mit absoluter Sicherheit das richtige Resultat bringen muss, und sich stattdessen damit zufrieden gibt, dass er dies mit sehr hoher Wahrscheinlichkeit tut, reduziert sich der Arbeitsaufwand von einer physikalisch unrealisierbaren Menge auf einen Aufwand von Sekundenbruchteilen. Für Mathematiker mag das unbefriedigend sein, für den Alltag aber reicht es längstens – die Wahrscheinlichkeit von fehlerhaften Resultaten ist oft kleiner als 1 geteilt durch die Anzahl der Protonen im Universum. Also winzig.

Diese Erkenntnisse führten zu einem Entwicklungssprung in der Kryptologie, dem wir heute Online-Banking und E-Commerce verdanken. Für die Informatik war das der Anfang eines wahren Paradigmenwechsels. Statt um mathematische Reinheit ging es von nun an ums Problemlösen. Wenn etwas wegen der hohen Berechnungskomplexität nicht funktioniert, dann muss man schauen, wie man die eigenen Anforderungen so reduziert, dass mindestens ein Teil des Gewünschten geliefert wird. Statt eines Optimums zielt man auf eine optimumsnahe Lösung, statt absoluter Korrektheit strebt man eine Korrektheit mit hoher Wahrscheinlichkeit an. Von nun an arbeitete man mit sogenannten Heuristiken als Algorithmen für Problemlösungen. Sie konnten mathematisch nicht mehr sauber analysiert werden, waren aber einfach und lieferten in der Praxis meistens zufriedenstellende Lösungen. Mit endlosen Verbesserungsmodifikationen, wie in technischen Disziplinen gut bekannt, hat man sie immer besser an die Praxisbedürfnisse angepasst.

4. Maschinen lernen selber

Heutiges «Big Data» bedeutet eine starke Vertiefung dieses Paradigmenwechsels von exakt überprüfbaren Berechnungen zum ingenieurartigen Probieren, Testen und Verbessern. Wir sprechen über «Big Data» nicht, wenn die Menge der zu verarbeitenden Daten eine gewisse feste Grösse überschreitet. Wir sprechen über «Big Data», wenn bisher benutzte und als effizient betrachtete Algorithmen nicht mehr für aktuelle Rechnertechnologien anwendbar sind, weil sie wegen der riesigen Menge von Inputdaten die gewünschte Information nicht extrahieren können. Das bedeutet, dass Problemstellungen, die bisher als «leicht» lösbar eingestuft worden sind, bei riesig grossen Eingaben nicht mehr praktisch lösbar sind. Wenn aus Kapazitätsgründen die gewünschte Information aus den Daten nicht rauszuholen ist, dann muss man Abstriche bei den eigenen Wünschen machen. Das bedeutet: man macht nur Schätzungen, die mit gewisser Wahrscheinlichkeit zu gewissem Mass zutreffend sind.

Diese umfangreiche Veränderung der Konzepte aus den 1970er Jahren ist aber nur ein Teil des Paradigmenwechsels. Als man versuchte, das Wissen von Experten in die Algorithmen einzubauen, scheiterte man früher nicht selten daran, dass man die Erfahrung und Intuition der menschlichen Experten nicht genau ausformulieren konnte. Heute baut man maschinelle Experten, die versuchen, nicht das unfassbare Wissen zu modellieren, sondern Schritt für Schritt zu erlernen – also wie menschliche Experten zu «wachsen». Man programmiert Algorithmen, die sich selbst ändern, wenn sie erkennen, dass sie einen Fehler gemacht haben, um diesen nicht zu wiederholen. Nach gewisser Trainingszeit erreichen sie in vielen Bereichen unglaubliche Erfolgsquoten. In vielleicht nicht mehr als sechs Jahren werden wir mit Uhren oder Handys herumlaufen, die permanent unseren Gesundheitszustand beobachten – und uns vor unterschiedlichen Erkrankungen warnen, lange bevor die ersten Symptome auftreten. Klar: auch die werden sich ab und zu irren, aber die Überprüfung falscher Diagnosen in den Krankenhäusern wird wesentlich weniger Kosten verursachen als die Behandlung ernsthafter, gesundheitlicher Probleme, die – wie bisher – zu spät erkannt werden.

Allgemein bedeutet es, dass wir in der Ära von «Big Data» versuchen, das Verhalten von Automatisierungssystemen näher an das menschliche Verhalten zu bringen. Man darf sich irren und aus den Fehlern lernen – und sich also weiterentwickeln. Die ganz genaue Bestimmung der Arbeit von Algorithmen anhand des exakten, verfügbaren Wissens wandelt sich zur Entwicklung von technischen Systemen, deren Verhalten und Fähigkeiten sich selbständig entwickeln und somit nicht genau vorhersehbar, weil beinahe organisch sind. Die Technik wird ihrem Verhalten nach also in gewissem Sinne immer menschlicher.

Eine neue, starke Beschleunigung der Erhöhung der Effizienz der menschlichen Zivilisation ist im Gange. Es werden viele Veränderungen im täglichen Leben auf uns zukommen – und das wahrscheinlich viel schneller, als wir es uns vorstellen.

5. Arbeit verändert sich

Diese Entwicklungen bringen grosse Chancen. Die Informatik befreit uns von ermüdender Routine und macht uns frei für erfinderische, kreative Tätigkeit. Gleichzeitig birgt sie auch Gefahren. Wir wollen an dieser Stelle nicht über die Vorstellungen von Science Fiction – ungehorsame Roboter, ausser Rand und Band geratene selbstfahrende Autos oder fehlgeleitete Gesundheitsinformationen aus Ihrer Armbanduhr – diskutieren. Das Hauptproblem jeder Effizienzsteigerung ist nicht deren mögliche zeitweise Fehleranfälligkeit, sondern unsere Lebenseinstellung als Menschen und möglicherweise unterschiedlich ausgeprägte Fähigkeiten, uns auf neue Zeiten einzustellen. Es droht durchaus eine Spaltung der Gesellschaft.

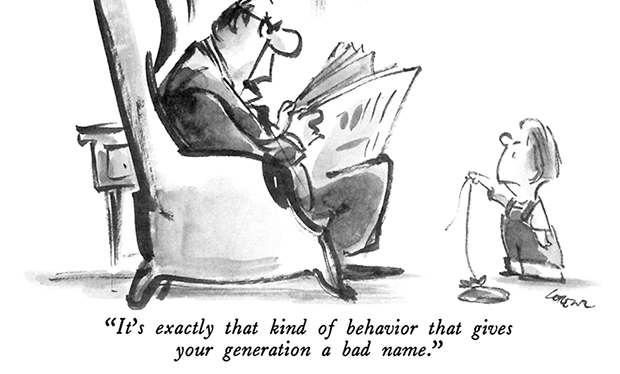

Die technische Revolution vor mehr als 100 Jahren hat die Menschheit in weiten Teilen von der monotonen und einseitigen physischen Arbeit befreit. Die Freiräume, die uns dadurch eröffnet wurden, konnte man etwa durch sportliche Tätigkeiten ersetzen und so den Körper durch ausgewogene Bewegung fördern. Die Reduktion der physischen Arbeit verlockte uns aber gleichzeitig zur körperlichen Inaktivität – und somit zur Degeneration des Körpers mit allen daraus abzuleitenden gesundheitlichen Nachteilen. Bei der jetzigen Revolution ist die Lage noch brisanter, denn in Zukunft geht es nicht mehr nur um potentielle Fettpolster, sondern um unser Gehirn und somit um unser intellektuelles Potential. Was ist damit gemeint?

Dank intensiver Automatisierung wird immer weniger menschliche Arbeit benötigt, um die menschliche Existenz zu garantieren. Um das Notwendige zu erhalten, wird es reichen zu lernen, die richtigen Knöpfe in richtiger Reihenfolge zu drücken, oder später: die eigenen Wünsche auszusprechen. Die Informationstechnologie wird uns von grossen Teilen der intellektuellen Arbeit «befreien». Die so gewonnene Zeit können wir nutzen, um uns kreativen, gestalterischen Tätigkeiten zu widmen und uns dadurch auch intellektuell viel weiter zu entwickeln, als unsere Vorfahren es je konnten. Das sind prinzipiell schöne Aussichten. Nur leider: wir können die gewonnene Zeit eben auch zum intellektuellen Degenerieren verwenden, indem wir nur noch das Notwendige – etwa Bedienungsanleitungen für vorhandene technische Systeme – lernen. In diesen grossen Freiräumen ist die Gefahr angelegt, dass sich die Gesellschaft in zwei Gruppen spaltet. Die eine wird täglich etwas Neues probieren, forschen, sich künstlerisch betätigen oder kreativ Neues gestalten und damit unsere Effizienz weiter beschleunigen und unser Leben verbessern. Diejenigen aber, die hier nicht teilnehmen und keine für die kreative Betätigung notwendige Qualifikation erreichen, könnten derweil ernsthafte Probleme bekommen, einen Platz in der Gesellschaft zu finden.

Leider scheint es mir, als hätten unsere Bildungsverantwortlichen das noch nicht verstanden – oder als weigerten sie sich, es zu verstehen. Wie wenig unsere Gesellschaft auf den Wandel im Bildungssystem vorbereitet ist, zeigten die Maturareform 1995 und der aktuelle Lehrplan 21: Die starke Tendenz, den Konsum von digitalen Technologien – statt Prozesse ihrer Gestaltung – zu unterrichten, spricht Bände. Ebenso der starke Fokus auf die Methodik, mit der aber die gleichen, alten Themen unterrichtet werden. Von einer Bildung, die Kreativität entfaltet und die Menschheit in der Weiterentwicklung ihres intellektuellen Potentials fördert, findet sich vielerorts keine Spur. Was könnten wir besser machen?

6. Die Bildung der Zukunft

Im Grunde müssen wir weg vom Erlernen von Fakten und fertigen Produkten der Wissenschaft. Stattdessen sollten wir meiner Ansicht nach unsere Fähigkeiten als Forscher und Tüftler stärken. Also lernen, wie man etwas Neues herausfindet und entdeckt, wie man eigene Hypothesen überprüft und andere davon überzeugt, dass das Entdeckte auch tatsächlich stimmt.

Entsprechend sollte man die Mathematik künftig erlernen als eine exakte Sprache zur Darstellung der Realität, als ein Forschungsinstrument also, statt einfach Algorithmen zur Lösung spezifischer künstlicher Probleme auswendig zu lernen. Die Naturwissenschaften werden uns Experimentieren und Hypothesenbildung beibringen und uns lehren, Instrumente zur Überprüfung der eigenen Vorstellungen zu entwickeln – und nicht Fakten vermitteln. Die technischen Wissenschaften werden über die Informatik und das Programmieren Einzug in die Bildung feiern und kreative, konstruktive und gestalterische Tätigkeiten zurück in die Schule bringen. Der Sprach- und Literaturunterricht wird sich entfernen müssen vom blossen Wiederkäuen der «richtigen Lesart» literarischer Werke, die oft wegen altersbedingter Unreife sowieso nicht wirklich verstanden werden, hin zum kreativen Schreiben. Oder einfacher: die Schule muss vom Wissensvermittler zum Wissenserzeuger werden. Verschliesst sie sich diesen Reformen, so verbaut sie den kommenden Generationen ihre Möglichkeit, kreative Arbeit in der Welt von morgen zu verrichten.